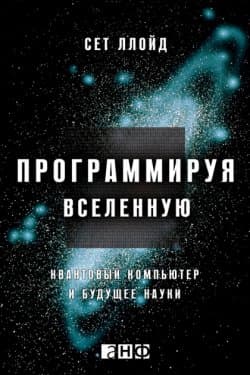

Программируя Вселенную. Квантовый компьютер и будущее науки - Сет Ллойд

-

Название:Программируя Вселенную. Квантовый компьютер и будущее науки

-

Автор:

-

Жанр:

-

Язык:Русский

-

Перевел:Анна Стативка

-

Издательство:Альпина Диджитал

-

Страниц:126

-

ISBN:978-5-91671-270-4, 978-5-91671-324-4

-

Рейтинг:

-

Ваша оценка:

Я с наслаждением пишу это особое вступление для издания книжки «Программируя Вселенную» на российском языке. Я желал бы поблагодарить Сергея Белоусова, Евгения Демлера, Мишу Лукина и всех сослуживцев из Русского квантового центра, которые несомненно помогли устроить вероятной публикацию сего российского перевода.»

Программируя Вселенную. Квантовый компьютер и будущее науки - Сет Ллойд читать онлайн бесплатно полную версию книги

Я несколько месяцев читал о разных методах определения сложности. Первой концепцией, на которую я обратил внимание, была вычислительная сложность. Вычислительная сложность равна числу элементарных логических операций, которые нужно выполнить в ходе вычисления. (Связанная с ней концепция, пространственная вычислительная сложность, равна числу битов, используемых в ходе вычисления.) Вычислительная сложность – не столько мера сложности, сколько мера усилий, или ресурсов, необходимых для выполнения данной задачи. Есть множество вычислений, занимающих много времени и расходующих много места, но они не производят ничего сложного. Как мы увидим, вычислительная сложность – важный ингредиент хорошего определения сложности, но сама по себе она не является хорошим определением.

В качестве меры сложности была также предложена алгоритмическая информация – кстати, Хайтин сначала назвал ее «алгоритмической сложностью». Но строки битов строки с высоким содержанием алгоритмической информации не выглядят сложными, они выглядят случайными; и действительно, алгоритмическую информацию также называют алгоритмической случайностью. Кроме того, строки битов с высоким содержанием алгоритмической информации легко создать: достаточно всего 100 раз подбросить монетку. Получившаяся строка битов, вероятно, будет иметь близкое к максимально возможному содержание алгоритмической информации. Мы с Хайнцем считали, что сложные вещи должны быть замысловатыми, структурированными и трудновоспроизводимыми. Для описания вещей с высоким содержанием алгоритмической информации может требоваться много битов, но почти все строки битов с высоким содержанием алгоритмической информации неструктурированны, и их легко создать.

Я продолжал читать, находя все больше определений сложности, но все они были вариациями на тему необходимых усилий или количества информации. Несколько лет спустя я сделал доклад об этих различных мерах сложности на конференции в Институте Санта-Фе, основанном в середине 1980-х Джорджем Коуэном, Мюрреем Гелл-Манном и группой старших научных сотрудников из соседнего Лос-Аламоса, которых интересовало изучение правил, дающих начало сложным системам и лежащих в их основе. Этот доклад назывался «Тридцать одна мера сложности» (Thirty-one Measures of Complexity), причем «тридцать один» было хорошо известным намеком на количество сортов мороженого Baskin-Robbins. Хотя я не опубликовал доклад под этим названием, молва о нем распространилась в Интернете, и в течение многих лет доклад о 31 способе измерения сложности был моей самой часто запрашиваемой работой, несмотря на то что ее просто не существовало. (Несколько лет назад я, наконец, опубликовал этот список в виде статьи{15}, просто для того, чтобы больше не отвечать на электронные письма, в которых меня просили выслать эту несуществующую статью.) Кстати говоря, за время от прочтения доклада до публикации статьи количество способов измерения сложности выросло с тридцати одного до сорока двух. (Длина нового списка побудила писателя Джона Хоргана в книге «Конец науки» (The End of Science) утверждать, что наука о сложных системах оказалась несостоятельной, так как исследователи не смогли договориться даже о том, что такое сложность, уже не говоря о каких-либо серьезных исследованиях в этой области.)

В этой статье я поделил меры сложности на четыре категории: во-первых, меры того, насколько сложно что-то описать (такие как алгоритмическая информация); во-вторых, меры того, насколько сложно что-то сделать (такие как вычислительная сложность); в-третьих, меры степени организации в системе; в-четвертых, неколичественные идеи о сложности (такие как самоорганизация или сложные адаптивные системы). Из этих сорока двух самыми интересными я считаю подходы, сочетающие в единой мере сразу три составляющие: насколько сложно что-то описать, насколько сложно что-то сделать и степень организации. О таких мерах мы и будем говорить ниже.

Никола Тесла. Повелитель Вселенной

Никола Тесла. Повелитель Вселенной  Длинный хвост. Новая модель ведения бизнеса

Длинный хвост. Новая модель ведения бизнеса  Мифология Ближнего Востока

Мифология Ближнего Востока  UX-стратегия. Чего хотят пользователи и как им это дать

UX-стратегия. Чего хотят пользователи и как им это дать  Великая тайна Вселенной. Вода

Великая тайна Вселенной. Вода  Рокировка

Рокировка  Пир теней

Пир теней  Князь во все времена

Князь во все времена  Когда порвется нить

Когда порвется нить  Пока я здесь

Пока я здесь